Crawl diepte beïnvloedt hoe efficiënt Google je content kan indexeren.

Googlebot heeft beperkte tijd en serverbronnen. Daarom is het crawlbudget, of het aantal pagina's dat Googlebot kan crawlen op je site gedurende een specifieke tijdsperiode, eindig.

Crawl diepte beïnvloedt ook de gebruikerservaring. Bezoekers kunnen moeite hebben om de benodigde informatie te vinden als essentiële inhoud moeilijk te vinden is door complexe navigatie of overmatige diepte.

In dit artikel zal ik uitleggen wat crawl depth betekent en waarom het belangrijk is in SEO.

Bovendien zal ik enkele tips delen om je te helpen de crawl-diepte van je website te verbeteren voor betere prestaties in zoekmachines.

Wat is Crawl Depth in SEO?

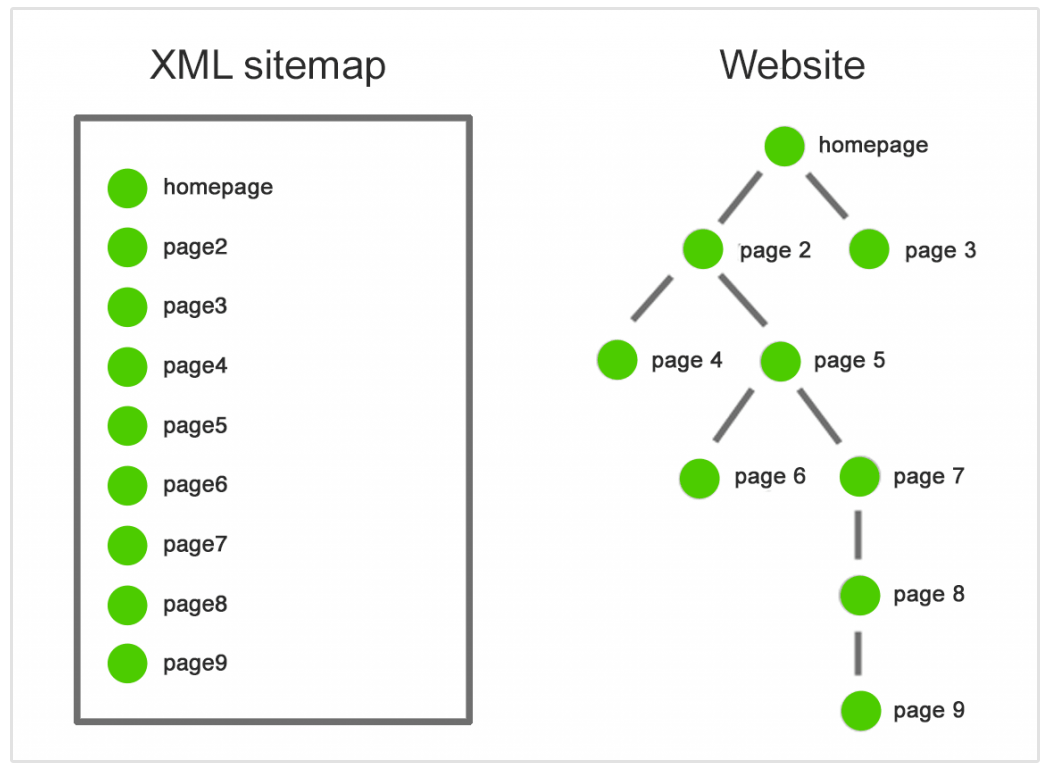

Crawl depth verwijst naar het niveau of de afstand waarop een webpagina zich bevindt binnen de hiërarchie van een website, gemeten vanaf de homepage.

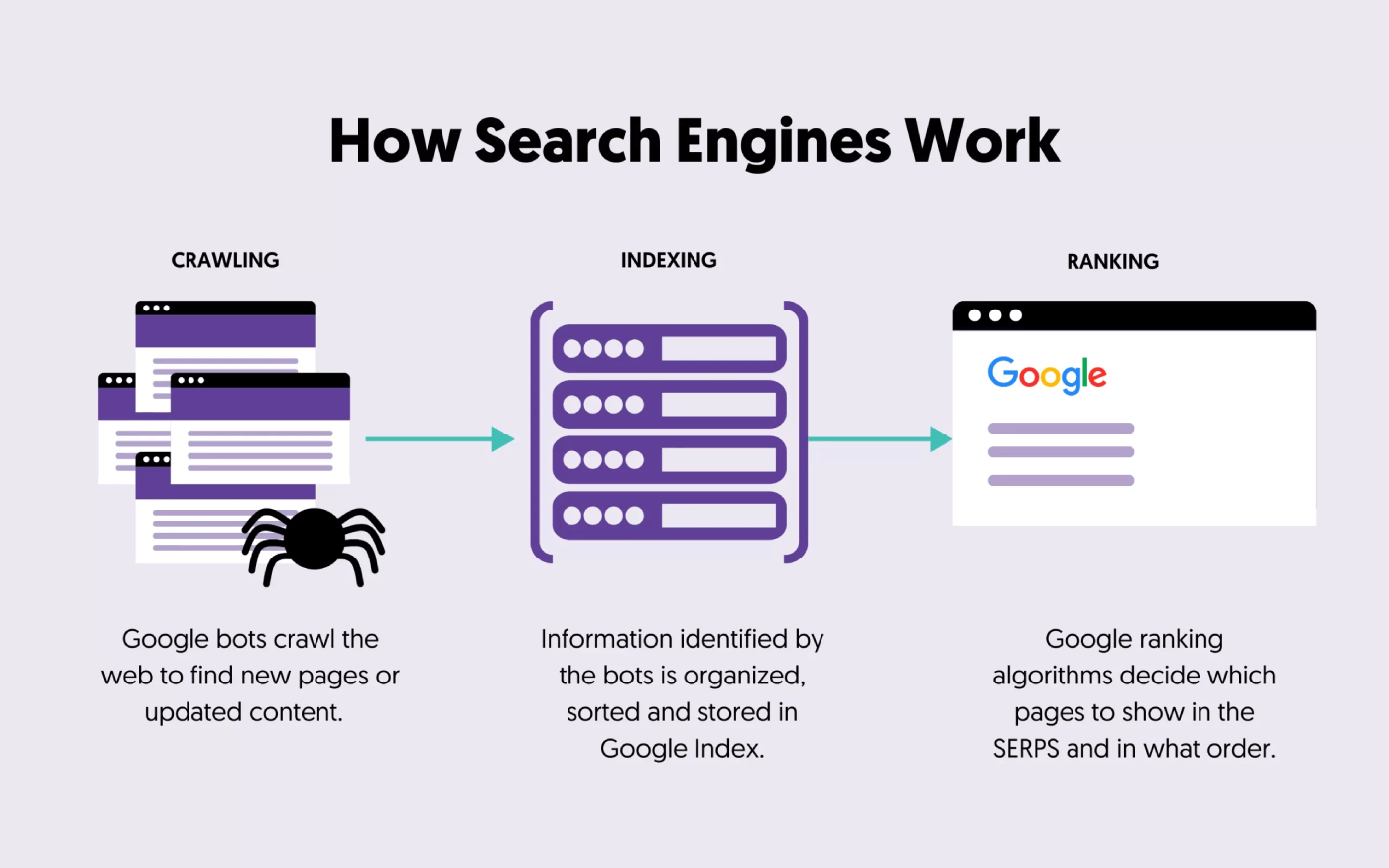

Het vertegenwoordigt hoeveel klikken of stappen een webcrawler van een zoekmachine nodig heeft om een bepaalde pagina vanaf de homepage van de website te bereiken. Crawl diepte is belangrijk omdat het kan beïnvloeden hoe effectief zoekmachines de inhoud van je website ontdekken en indexeren.

Stel je voor dat je een website hebt met de volgende structuur:

Homepage > Categorie A > Subcategorie A1 > Pagina 1

De homepage heeft een crawl-diepte van 0 in dit voorbeeld omdat het het startpunt is. Subcategorie A1 heeft een crawl-diepte van 2 omdat het twee klikken van de homepage verwijderd is, en Pagina 1 heeft een crawl-diepte van 3 omdat het drie klikken van de homepage verwijderd is.

Waarom is Crawl Depth Belangrijk in SEO?

Crawl diepte is belangrijk in SEO om verschillende redenen:

- Indexeringsefficiëntie: Pagina's die diep begraven liggen binnen de structuur van een website worden mogelijk niet zo vaak gecrawld en geïndexeerd als die dichter bij de homepage.

- Link Equity: Pagina's dichter bij de homepage ontvangen vaak meer "link equity" (autoriteit) via interne en externe links. Dit kan hun zoekmachinerangschikkingen en zichtbaarheid beïnvloeden.

- Gebruikerservaring: Een complexe en diepe websitestructuur kan het voor gebruikers en zoekmachines moeilijk maken om belangrijke inhoud te vinden, wat mogelijk leidt tot een slechte gebruikerservaring.

- Versheid: Pagina's met een geringe crawldiepte worden waarschijnlijk vaker gecrawld, waardoor zoekmachines updates en wijzigingen sneller kunnen detecteren en indexeren.

Hoe de efficiëntie van de crawl-diepte te verhogen

Hier zijn enkele van de beste manieren om de efficiëntie van de crawl-diepte te verbeteren:

Regelmatig Sitemap Bijwerken

Door het indienen van uw sitemap, maakt u het eenvoudiger voor zoekmachines om uw webpagina's snel te crawlen en indexeren.

Het is cruciaal te benadrukken dat sitemaps dynamisch moeten blijven en altijd de meest actuele status van je website moeten weerspiegelen.

Vergeet niet om je sitemap dienovereenkomstig bij te werken wanneer je nieuwe pagina's toevoegt, bestaande bijwerkt of verouderde inhoud verwijdert. Dit zorgt ervoor dat zoekmachines altijd toegang hebben tot een nauwkeurige en uitgebreide lijst van de URL's van je website.

Verbeter de Navigatie en Structuur van de Website

Het verbeteren van de navigatie en structuur van je website is fundamenteel voor webdesign en SEO.

Begin met het stroomlijnen van je navigatiemenu's, het logisch categoriseren van inhoud en het gebruiken van duidelijke, beschrijvende labels. Creëer een duidelijke hiërarchie voor je website, waarbij je ervoor zorgt dat subcategorieën en pagina's zijn georganiseerd onder relevante hoofdcategorieën.

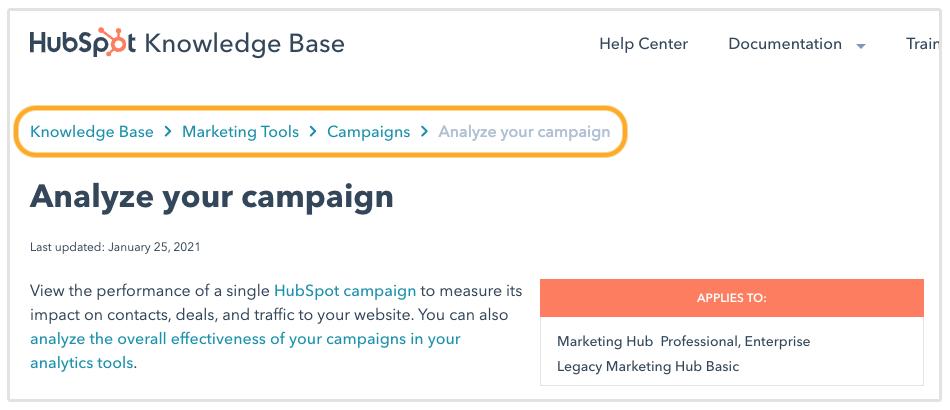

Implementeer broodkruimelnavigatie om gebruikers en zoekmachines door de structuur van uw site te leiden.

Ten slotte, optimaliseer je URL-structuur om schone en beschrijvende URL's te maken en een up-to-date XML-sitemap bij te houden om zoekmachine-indexering te ondersteunen.

Meer Interne Links Toevoegen

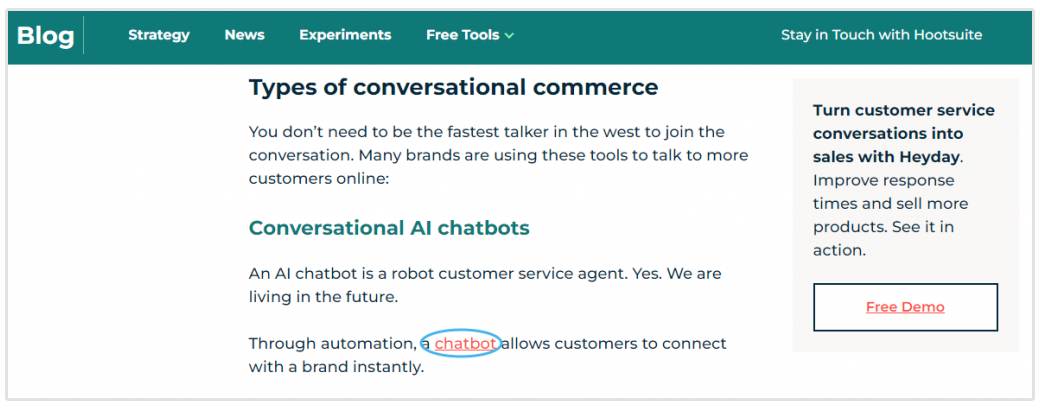

Interne links zijn belangrijk om zoekmachinecrawlers door je website te leiden.

Wanneer je strategisch interne links toevoegt binnen je content, bied je duidelijke paden voor zoekmachinebots om van de ene pagina naar de andere te volgen.

Het toevoegen van interne links naar verschillende pagina's op je site stelt je in staat om de crawlactiviteit gelijkmatiger te verdelen. Dit zorgt ervoor dat verschillende delen van je website aandacht krijgen van zoekmachinebots, waardoor wordt voorkomen dat sommige pagina's over het hoofd worden gezien.

Bovendien moedigen interne links zoekmachinebots aan om dieper in de hiërarchie van je site te duiken. Wanneer belangrijke pagina's vanuit meerdere bronnen worden gelinkt, geeft dit aan zoekmachines aan dat ze belangrijk zijn en grondig geïndexeerd moeten worden.

Websiteprestaties verbeteren

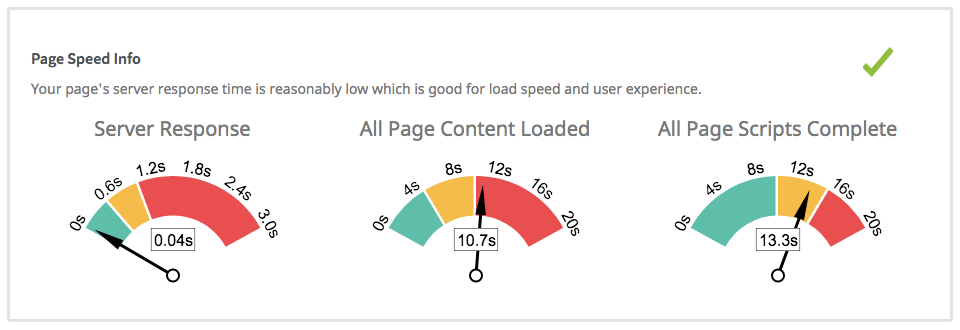

Het verbeteren van de prestaties van de website heeft direct invloed op de crawlsnelheid.

Een snel ladende website met geoptimaliseerde afbeeldingen, minimale HTTP-verzoeken, efficiënte serverresponstijden en verminderde serverbelasting kan de efficiëntie van zoekmachinecrawlers aanzienlijk verbeteren.

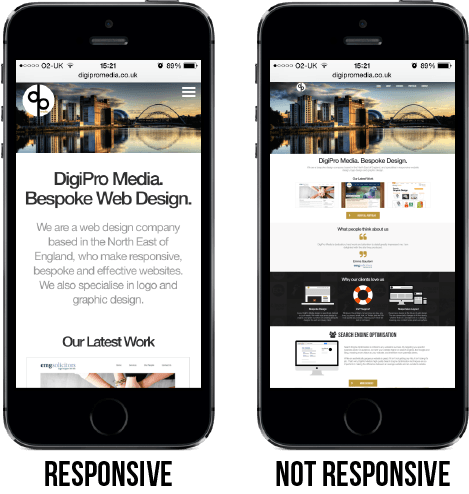

Wanneer een website responsief is en snel laadt, kunnen zoekmachines de pagina's sneller en efficiënter crawlen. Dit betekent dat zoekmachinebots meer terrein kunnen bestrijken binnen het toegewezen crawlbudget, wat leidt tot een meer uitgebreide indexering van de inhoud van je site.

Gelukkig hebben de meeste websitebouwers en moderne Content Management Systemen mobiel-responsieve thema's.

Als gevolg hiervan biedt een goed presterende website een verbeterde gebruikerservaring en faciliteert snellere en grondigere zoekmachine-indexering, wat een positieve invloed kan hebben op je SEO-rangschikkingen.

Wat kan Crawl Depth Problemen Veroorzaken?

Hier zijn veelvoorkomende factoren die kunnen leiden tot problemen met crawl-diepte:

- Complexe Website Structuur: Websites met overdreven complexe hiërarchieën en diepe navigatiepaden kunnen het voor zoekmachinebots moeilijk maken om snel diepere pagina's te bereiken. Deze complexiteit kan het gevolg zijn van overmatige subcategorieën of inefficiënte organisatie.

- Onvoldoende interne koppelingen: Als je website onvoldoende interne koppelingen heeft, met name koppelingen die naar diepere pagina's wijzen, kunnen zoekmachinebots moeite hebben om die pagina's te ontdekken en te crawlen. Onvoldoende interne koppelingen beperken de paden die crawlers kunnen volgen.

- Verweesde Pagina's: Verweesde pagina's zijn pagina's zonder interne links die naar hen verwijzen. Wanneer pagina's geïsoleerd zijn van de rest van de website's structuur, kunnen zoekmachines ze mogelijk niet gemakkelijk vinden en indexeren.

- Gebroken Links en Redirect Chains: Gebroken links of onjuiste redirects kunnen het crawlen verstoren. Zoekmachinebots kunnen doodlopende wegen of circulaire redirectketens tegenkomen, waardoor ze geen toegang hebben tot diepere pagina's.

- Trage laadtijden van pagina's: Pagina's met trage laadtijden kunnen zoekmachinebots frustreren, waardoor ze de crawl voortijdig verlaten. Trage pagina's kunnen de indexering van diepere inhoud belemmeren.

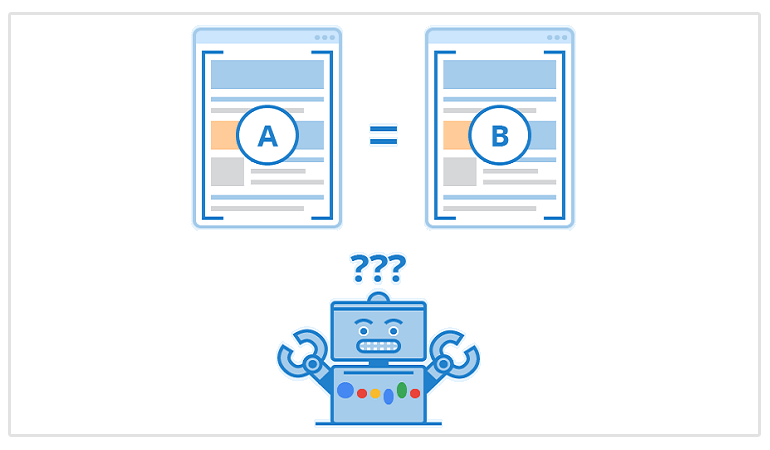

- Dubbele Inhoud: Problemen met dubbele inhoud kunnen zoekmachinebots verwarren, wat leidt tot inefficiënt crawlen. Wanneer bots meerdere versies van dezelfde inhoud tegenkomen, geven ze mogelijk niet de prioriteit aan het indexeren van alle exemplaren.

- Noindex Tags: De "noindex" meta tag of directive instrueert zoekmachines om bepaalde pagina's niet te indexeren. Wanneer essentiële pagina's per ongeluk deze tag hebben, kan dit hun aanwezigheid in zoekresultaten verminderen, wat hun zichtbaarheid kan beïnvloeden.

- Changes in Website Structure: Frequente wijzigingen in de structuur van je website zonder juiste omleiding of bijwerking van interne links kunnen zoekmachinebots in verwarring brengen. Ze kunnen proberen niet-bestaande of verouderde pagina's te crawlen.

Conclusie

Crawl diepte is van vitaal belang in hoe zoekmachines de inhoud van je website ontdekken en indexeren. Het beïnvloedt de indexeringsefficiëntie, SEO-prestaties, gebruikerservaring en hoe vaak Googlebot je pagina's opnieuw bezoekt.

Door de structuur van je website, interne links en andere technische aspecten te optimaliseren, kun je ervoor zorgen dat belangrijke inhoud de aandacht krijgt die het verdient van zoekmachines.